- Les méthodes de maîtrise statistique des processus (SPC pour Statistical Process Control) sont depuis longtemps mises en œuvre par les entreprises pour l’amélioration de la qualité de leurs produits.

- Cependant, les méthodes SPC traditionnelles ne sont plus de nos jours en adéquation avec l’hypothèse fondamentale qui suppose la stabilité du procédé.

- Du fait de la complexité grandissante des processus de fabrication électronique, elles s’avèrent inefficaces pour une gestion d’un haut niveau de qualité compte tenu de la quantité croissante de données à traiter.

- Une approche conforme à la philosophie Lean Six Sigma, permettant un élargissement de la portée du SPC, est bien plus appropriée pour identifier et hiérarchiser des actions pertinentes conduisant à l’amélioration des processus.

- Virinco en explique les raisons dans cet article.

- Virinco dispose de plus de 20 ans d’expérience dans le domaine du conseil en ingénierie et en déploiement de solutions PLM (Product Lifecycle Management) axés sur la fabrication.

Aspect historique

Les méthodes SPC sont apparues dans les années 1920 afin de répondre aux exigences de production de l’époque. L’un de leurs objectifs est de permettre de détecter précocement des dysfonctionnements afin d’y remédier rapidement et de procéder à des améliorations. Les méthodologies SPC disposaient d’un volume d’informations bien moindre que celui que peuvent fournir aujourd’hui les systèmes de production modernes. En se référant simplement à la fameuse la loi de Moore, il est évident que la complexité et les performances des technologies informatiques ont depuis considérablement évolué, de même que celles des produits électroniques fabriqués. De fait, les mesures collectées il y a plusieurs décennies lors des différentes phases de fabrication sont incomparables tant en nombre, en diversité et en complexité à celles traitées aujourd’hui par les processus de production. Compte tenu de cette complexité croissante ainsi que d’autres facteurs tels que l’augmentation des volumes de production, liée notamment à mondialisation, il en résulte que la quantité et le type de données à prendre en compte n’ont aujourd’hui rien à voir avec ceux qui étaient en jeu dans les années 1920.

Limitations fondamentales

Les méthodes SPC tiennent encore une place prépondérante chez les fabricants OEM (Original Electronics Manufacturers). Elles sont mises en œuvre pour le contrôle de procédés de fabrication continue, pour calculer des valeurs d’alerte et pour détecter la non conformité des paramètres du process. En théorie, le dépassement de valeurs limites permet d’avertir d’une dégradation du process. Mais la théorie reste bien théorique. Le SPC repose sur une hypothèse fondamentale selon laquelle vous êtes en mesure d’éliminer ou de prendre en compte les variations de cause commune du processus[1]. Toutes les autres variations sont donc considérées comme spécifiques.

Un produit électronique peut aujourd’hui comporter des centaines de composants. Sa conception évoluera sensiblement au fil du temps notamment en raison de l’obsolescence des composants qu’il embarque. Le produit sera soumis à différents tests au cours du processus d’assemblage, son firmware sera mis à jour régulièrement de même que les applications logicielles de test. Les opérateurs, la variation de facteurs environnementaux, ainsi que d’autres éléments auront une influence sur le process de fabrication et de test.

Exemple de hautes dynamiques

Prenons par exemple le cas de la société Aidon, fabricant de produits de comptage intelligent. Selon son responsable de production, Petri Ounila, un lot de fabrication comprend en moyenne 10 000 unités dont chacune intègre plus de 350 composants électroniques avec plus de 35 changements de composants tout au long de ce processus de fabrication.

Ce qui conduit à traiter un « nouveau » produit ou processus toutes les 280 unités fabriquées. Il faut ajouter à cela les modifications du processus de test, des montages, des programmes de test, de l’instrumentation, etc. Au final, on peut estimer que le procédé change en moyenne toutes les 10 unités voire moins. En d’autres termes, 1000 processus distincts sont mis en œuvre pour la fabrication d’un seul lot.

Comment tenteriez vous d’éliminer les variations de cause commune ? Devriez vous le faire?

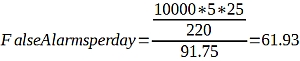

Même si vous y parveniez, comment feriez-vous pour mettre en place le système d’alerte approprié ? Une méthode SPC connue sous le nom de Western Electrical Rules (WECO), développée par Western Electric Company en 1956, spécifie certaines règles nécessitant un examen approfondi lors qu’une violation est constatée, selon l’écart constaté entre la valeur observée et les écarts-types[2]. L’un des inconvénient typiques de la méthode WECO est qu’elle déclenchera en moyenne une fausse alarme tous les 91,75 mesures non liées.

Fausses alarmes à foison !

Supposons que votre volume de production annuel soit de 10 000 unités. Si chacune d’elle est soumise à cinq étapes de test distinctes mettant en œuvre en moyenne 25 mesures, au final, vous obtiendrez en moyenne jusqu’à 62 fausses alarmes par jour, sur la base de 220 jours ouvrables par an.

Fausses alarmes par jour

Sachez que, même en supposant, contre toute attente et quelle qu’en soit la raison, vous soyez à même d’éliminer les variations de cause commune, vous recevriez encore 62 alertes chaque jour. Toute personne recevant 62 courriers électroniques quotidiennement d’un même expéditeur les bloquerait probablement, sans accuser réception ou assurer le suivi d’informations potentiellement importantes. Les utilisateurs expérimentés en méthodologies SPC feront probablement valoir qu’il existe des moyens de réduire ce phénomène par la mise en œuvre de nouvelles méthodes d’analyse plus performantes. « Il y a les règles de Nelson, nous avons l’AIAG, vous devriez absolument utiliser les règles de Juran ? Vous devez identifier les structures d’autocorrélation pour réduire le nombre de fausses alarmes ! Et ce graphe d’avant garde développé au début des années 2000, si on le mettait en œuvre? »

Alors quoi ? ? Même si nous parvenions à réduire à cinq le nombre de fausses alarmes quotidiennes, pourrait-il être considéré comme un système d’alerte stratégique ? En prenant en compte la dynamique réelle du processus, le SPC peut-il constituer un système fiable pour les responsables de la fabrication ? Une méthodologie qui les libère de leurs préoccupations et des maux qui s’en suivent.

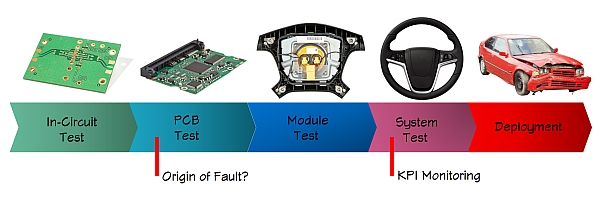

Saisissez les indicateurs de performance clé

La plupart du temps, il s’agit d’établir des hypothèses sur un ensemble limité de paramètres pertinents à surveiller et de les suivre attentivement en traçant leur évolution dans des graphiques de surveillance, des graphes X-mR ou tout autre outil pour tenter de séparer le bon grain de l’ivraie. Ces indicateurs de performance sont en réalité très souvent collectés et analysés bien en aval du processus de fabrication, après la combinaison de plusieurs sous-ensembles dans un système.

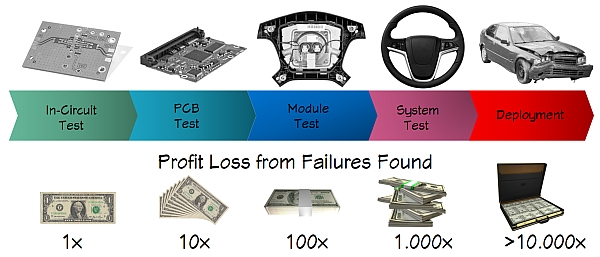

Une conséquence évidente de cette situation est que les problèmes ne sont pas détectés là où ils surviennent, au fur et à mesure qu’ils apparaissent. L’origine pourrait tout à fait provenir de l’un des composants ou procédés en amont, fabriqué il y a un mois au sein d’un lot qui représente maintenant 50 000 unités. Une règle bien connue stipule que si un défaut survient à une étape du processus de fabrication, la défaillance va s’accentuer et à chaque étape le coût de la réparation augmente d’un facteur 10. Une défaillance constatée en fin de fabrication pourra nécessiter le démontage du produit par des techniciens ce qui, peut induire de nouveaux défauts. Si un défaut gagne du terrain, les conséquences financières peuvent être catastrophiques. Il existe de nombreux exemples récents d’entreprises qui ont dû se déclarer en faillite ou s’en protéger en raison de la perspective de rappels massifs de produits défaillants. Un exemple récent est le dépôt de bilan de Takata après un rappel massif de plus 100 millions de composants d’airbags[3].

L’un des principaux défauts inhérent à la méthodologie SPC, selon les standards de méthodologies modernes telles que le Lean Six Sigma, est qu’elle établit des hypothèses sur l’origine des problèmes. Il s’agit là d’une conséquence évidente de l’hypothèse d’une stabilité du processus alors qu’il dépend, comme nous l’avons mentionné précédemment, de facteurs très dynamiques. L’observation des tendances et le suivi d’un ensemble limité d’indicateurs de performance ne font qu’accentuer ce défaut. Encore une fois, cela donne lieu à des initiatives d’amélioration susceptibles d’échouer en se focalisant sur vos problèmes les plus urgents ou rentables.

Une approche moderne

Tout cela est pris en compte dans les méthodes modernes de gestion de la qualité.

Dans le domaine de la fabrication électronique, cela commence par une reconnaissance et un suivi sincère de votre taux de produits conformes au premier passage (FPY pour First Pass Yield). Votre True FPY pour être plus précis. Par True (vrai), on entend que tout type de défaillance doit être comptabilisée, quelle qu’en soit la cause même si elle est la conséquence d’un simple oubli du branchement d’un câble par un opérateur de test. Tous les tests après le premier constituent un gaspillage des ressources que l’entreprise auraient pu mieux exploiter ailleurs. Le True FPY représente sans doute le seul indicateur clé (KPI) le plus important, mais la plupart des OEM n’ont pas la moindre idée de ce qu’est le leur.

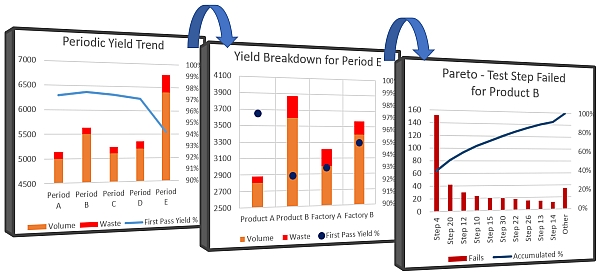

Les tableaux de bord en temps réel et les fonctions de décomposition vous permettent d’identifier rapidement les facteurs qui contribuent aux mauvaises performances. Il apparaît ici qu’une seule défaillance du produit B contribue à environ 50 % des rebus. Il n’y a aucune garantie que l’étape 4 fasse partie des indicateurs clés surveillés au sein d’un système SPC. Il est cependant essentiel que son évolution soit portée à votre attention.

Tableaux de bord en temps réel

Connaissant votre FPY, vous pouvez le décomposer en parallèle entre différents produits, familles de produits, usines, stations, montages, opérateurs et systèmes de test. Le fait de disposer de ces données en temps réel sous forme de tableaux de bord vous donne une puissante vue de contrôle. Ce qui vous permet d’analyser rapidement l’origine réelle des sous-performances et d’intervenir selon des critères économiques. La mise à disposition de ces informations sous forme de tableaux de bord en temps réel à toutes les parties prenantes concernées contribue également à une plus grande responsabilisation en matière de qualité. Une bonne règle empirique pour le tableau de bord est qu’à moins que l’information ne vous soit donnée, elle ne sera pas suivie d’effet. Nous n‘avons tout simplement pas le temps de chercher les ennuis.

A l’étape suivante, il est probablement essentiel que vous soyez en mesure d’obtenir rapidement une vue Pareto de vos défaillances les plus fréquentes dans toutes leurs dimensions. Il se pourrait alors que les outils de SPC deviennent pertinents afin de vous fournir davantage d’informations détaillées. Mais maintenant, vous savez que vous les appliquez sur des éléments très pertinents, et non des conjectures. Vous vous retrouvez soudainement dans une situation où vous pouvez prioriser les initiatives en fonction d’un rapport coûts-avantages réaliste.

Données de réparation

Il est également essentiel que les données de réparation soient prises en compte par votre système. Ces données ne peuvent pas être exclusivement traitées par un système MES ou un outil de réparation externe. Elles fournissent des données contextuelles qui améliorent l’analyse des causes profondes, en plus de fournir d’autres informations pertinentes. Du point de vue des ressources humaines, il peut également vous indiquer si les produits sont retestés à l’aveugle, car parfois les variations normales du processus relèvent la mesure entre les valeurs limites indiquant la réussite et l’échec d’un test. Ou si le produit est en fait retiré de la chaîne de fabrication standard et réparé, comme prévu. Ne vous faites pas d’illusions, il n’est pas rare que des produits soient retestés plus de 10 fois dans la même heure.

En bref, les actions impactant la qualité proviennent de décisions éclairées. Si vous ne disposez pas d’une approche de gestion des données capable de vous délivrer une vue d’ensemble, vous ne pourrez jamais optimiser la qualité de vos produits et de vos processus ou les bénéfices de votre entreprise.

Vous ne pouvez pas réparer ce que vous ne mesurez pas.

[1] https://en.wikipedia.org/wiki/Statistical_process_control

[2] https://en.wikipedia.org/wiki/Western_Electric_rules

[3] https://www.reuters.com/article/us-takata-bankruptcy-analysis/with-new-takata-air-bag-recalls-automakers-may-face-more-liabilities-idUSKBN1A40X5